NVIDIA se positionne devant AMD au niveau des performances des cartes graphiques. AMD ne se laisse pas faire et Lisa Su, le PDG de la Société AMD a plus d’un arc dans ses cordes. La nouvelle carte RX 6900 XT connue aussi sous le nom de Big Navi XT abritant un GPU Navi 21 XTX est-elle plus performante que la NVIDIA GeForce RTX 3090 ? Le 28 octobre prochain, AMD présentera ses nouvelles cartes, mais en attendant analysons de plus près les informations que nous pouvons soutirer de l’image du PCB du RX 6900 XT.

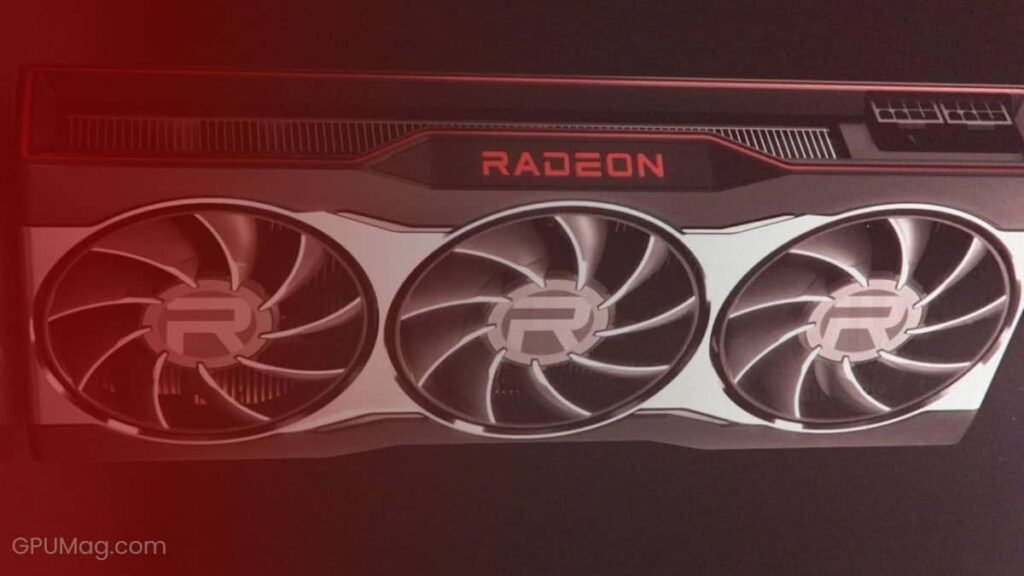

Le PCB de la Radeon RX 6900 XT

Le GPU n’est pas visible mais sa taille peut être appréciée sur l’image. Cette carte consommera moins que la RTX 3090 car le système de phase est composé de 16 chiffres (14 + 2) bien qu’elle nécessitera toujours une alimentation de 2x à 8 pins. Nous remarquons que les 2 radiateurs demi-taille qui protègent les VRAM ne sont pas en contact direct avec le radiateur principal du GPU. Le système de ventilateurs refroidira le tout mais cette architecture privilégie une meilleure dissipation de chaleur au niveau du GPU. Les points de soudure suggèrent que la carte aurait 8 ou 16 Go de mémoire.

Source GPUMAG.COM

Configurations de la RX 6900 XT

Le GPU de la RX 6900 XT suit les process de fabrication à 7 nanomètres de TSMC. C’est un léger avantage par rapport à celui de son concurrent qui est normé à 8 nm par Samsung. Il comporte 5120 de processeurs shaders et travaille sur une fréquence gaming de 2,04 GHz. En fréquence boost, les 23.000 millions de transistors commutent à 2,33 GHz. La carte Big Navi XT est équipée de 16 Go de mémoire GDDR6 avec un bus mémoire de 256 bits. Sa concurrente RTX 3090 dispose par contre de 24 Go de mémoire GDDR6X et son GPU fonctionne sur une fréquence de commutation de 1,7 GHz en mode boost. La RX 6900 XT consomme une puissance TDP estimée de 255 W contre 350 Watts pour la Geforce RTX 3090. Côté connectiques, la carte AMD comporte 1 port HDMI, 2 Display Port et 1 port USB-C.

Il est à rappeler que la carte Geforce RTX 3090 est très performante et permet de visualiser des images HDR 8K en 60 FPS. De plus, elle exploite l’IA pour pousser à l’extrême ses capacités (échantillonnage par DLSS, RayTracing etc.) Néanmoins, selon les dernières rumeurs, la Big Navi XT dépasse largement la RTX 3080 en terme de performance et se trouve juste derrière la RTX 3090. Attendons d’avoir sous la main cette nouvelle carte pour procéder à son benchmarking. En tout cas, si cela s’avère juste, les cartes AMD auraient doublé de performance et AMD rattrape son retard sur NVIDIA.

Pour rappel, la carte RTX 3090 est déjà en vente sur le site de NVIDIA ou Amazon. Nous imaginons que AMD et son équipe commerciale mettre en vente la RX 6900 XT à un prix légèrement au-dessous pour attirer plus de clientèle. Rendez-vous donc ce 28 octobre 2020 pour avoir les informations détaillées.