La carte EVGA GeForce GTX 1660 Super est une évolution des cartes Geforce GTX 1660 et Geforce GTX 1650. Cette carte a été mise en vente pour la première fois par Nvidia le 29 octobre 2019 dernier. Cet article vous permet de découvrir les caractéristiques et les performances de cette carte de moyenne gamme. Nvidia a lancé officiellement des GPU basés sur le turing en septembre 2018. Cette carte est justement fabriquée à base de cette architecture. Elle est disponible sur le net pour le prix de 250 € environ.

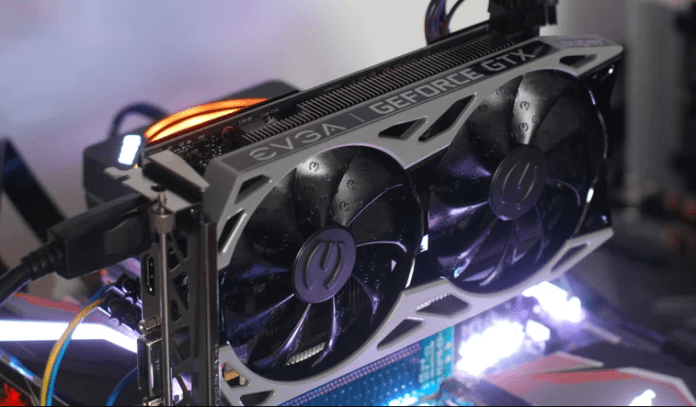

Présentation de la carte EVGA GeForce GTX 1660 Super

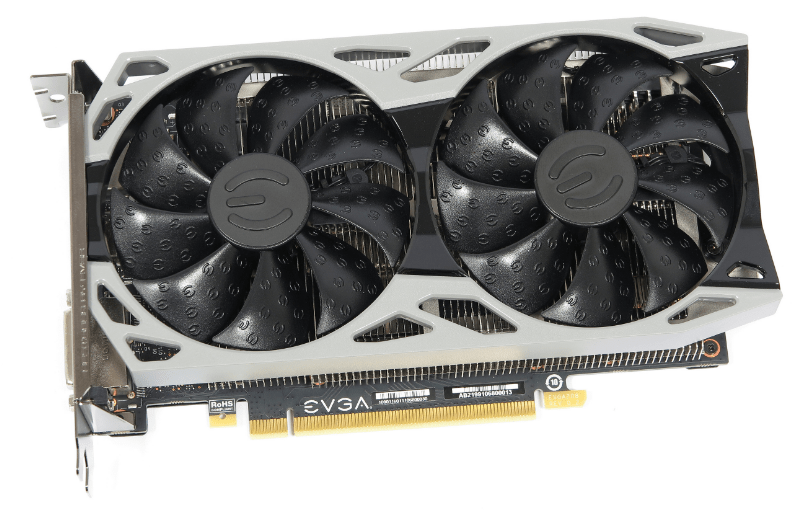

La GeForce GTX 1660 est connectée sur la carte mère via son interface PCI Express 3.0 16x. Elle possède 3 ports de sortie vidéo : 1 DisplayPort, 1 HDMI et 1 DVI. La GTX 1660 Super mesure 202,1 mm x 111,15 mm et occupe un emplacement de 2 slots. Sa taille mini lui permet d’être installée sur n’importe quel UC. Elle consomme 125 Watts. Soit à 5 watts de plus de la GTX 1660 de base. Nous recommandons une puissance de 500 Watts au minimum pour le bloc d’alimentation du PC.

Il faut savoir que Nvidia n’a pas fourni de modèle de référence pour la carte GTX 1660 Super. Ainsi, chaque constructeur partenaire fournit des personnalisations sensiblement différentes. Pour le cas d’EVGA, la SC Ultra Gaming comprend 2 ventilateurs centraux recouvrant le radiateur thermique. Ce dernier est formé d’une plaque cuivrée qui se met directement en contact avec le GPU. La mémoire VRAM n’est pas par contre en contact avec la plaque de cuivre. Elle est refroidie par le flux d’air issu des 2 ventilateurs. Le système de refroidissement se coupe automatiquement quand la température du GPU est inférieure à 50 °C. Ce qui contribue à une meilleure gestion énergétique. Le bruit occasionné par le ventilateur est relativement perceptible mais tolérable.

Elle ne comporte pas d’éclairage LED RGB mais est dotée d’une carrure noire assez rigide et compacte. La carte GTX 1660 Super offre une possibilité d’overcloking assez intéressante. Ce qui lui permet d’être largement plus performante que la GTX 1660 standard et de frôler les performances de la GTX 1660 Ti. En résolution graphique, la carte GTX 1660 Super est à 20 % plus performante que la carte GTX 1660 de base et à -3% de la GTX 1660 Ti.

Caractéristique de la GeForce GTX 1660 Super

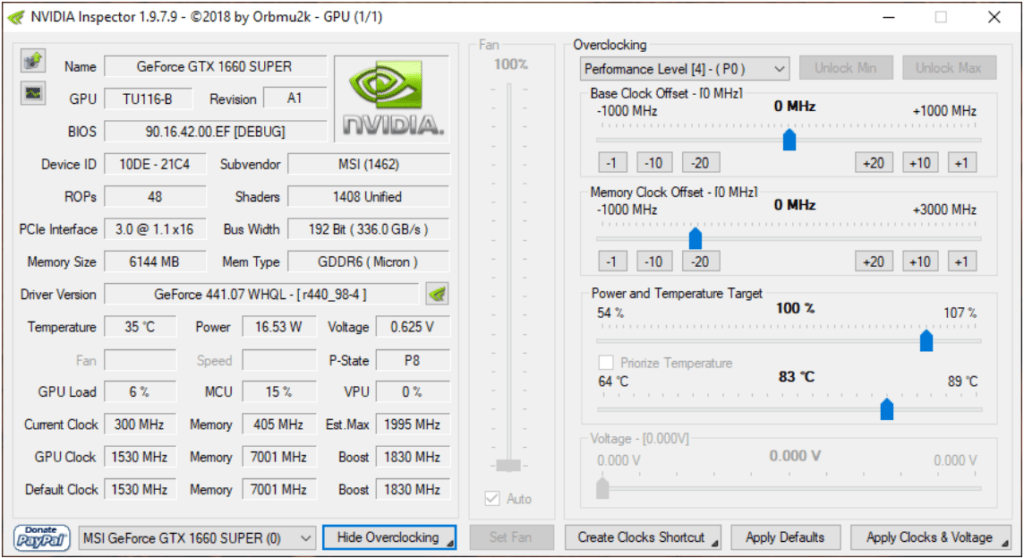

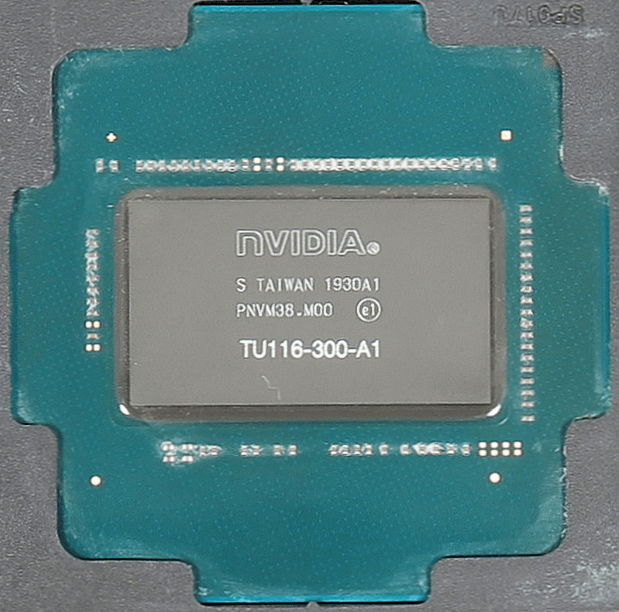

Cette carte GeForce GTX 1660 Super se positionne en terme de performance entre la GeForce GTX 1660 et la GeForce GTX 1660 Ti. Les cartes de série Super ont été lancées par Nvidia pour fournir des cartes de meilleur rapport qualité-prix. La GeForce GTX 1660 Super possède un GPU TU116-300 avec 1408 coeurs CUDA, 48 ROPS et 88 TMU. La carte est dotée de 6 Go de mémoire GDDR6 transitant des données à 14 Gbps sur un bus mémoire de 192 bits. Ce dernier est composé de 6 contrôleurs à 32 bits chacun. Le GPU est fabriqué sous un processus de gravure à 12 nanomètres par TSMC dans une dimension de 284 mm². La GTX 1660 est quant à elle dotée d’une mémoire GDDR5 à 8 Gbps. La GTX 1660 Super bénéficie ainsi d’une technologie de mémoire 75 % plus rapide.

La GTX 1660 Super commute ses transistors intégrés à 1,53 GHz. Ces derniers sont au nombre de 6,6 milliards. En boost clock, son GPU fonctionne à 1,83 GHz.

Les plus de la carte EVGA GeForce GTX 1660 Super

Cette carte bénéficie de différentes fonctionnalités logicielles qui lui permettent d’être plus performante. La fonctionnalité NULL ou Ultra Low Latency Mode permet d’éviter la latence quand le frame rate par seconde dépasse la fréquence de rafraichissement de l’écran. Associée à la fonction G-sync, NULL permet de réduire drastiquement la latence.

La fonction ReShade permet quant à elle d’appliquer des filtres en temps réel. Les filtres peuvent être appliqués au jeu ou bien aux captures d’écran via Ansel ou Freestyle de GeForce Experience. Pour les activer, vous pouvez utiliser les raccourcis claviers : Alt + F2 pour Ansel et Alt + F3 pour Freestyle.

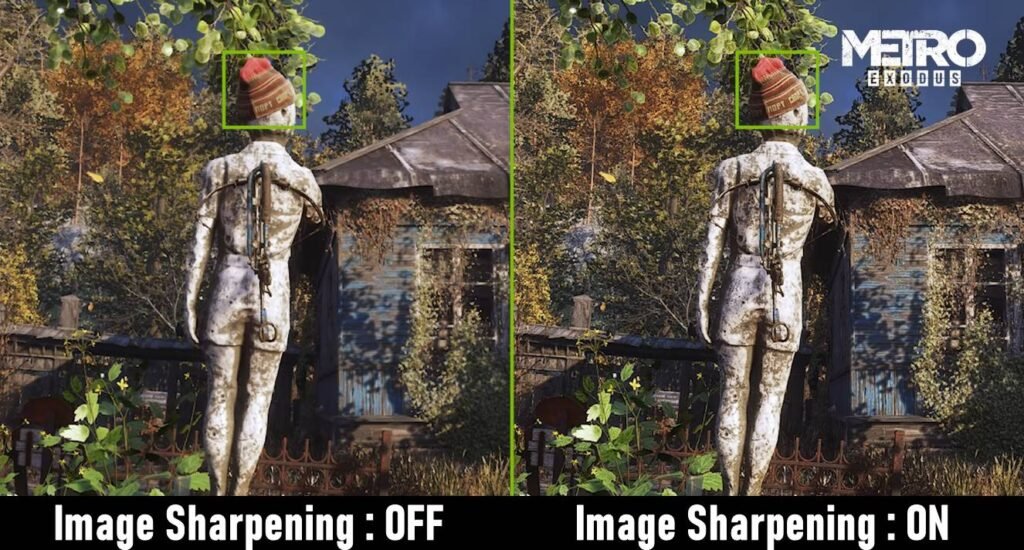

La fonctionnalité Image sharpening est disponible à partir de Freestyle mais aussi dans le panneau de configuration Nvidia. Cette application accroit la performance graphique. Elle est disponible pour les jeux compatibles DirectX 9, DirectX 11 et Direct X 12.

Benchmarking de la GeForce GTX 1660 Super

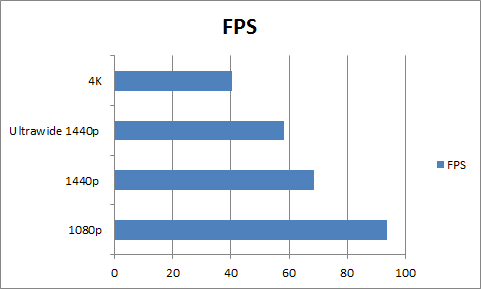

La GTX 1660 Super affiche une performance graphique assez élevée dans sa catégorie de carte de moyenne gamme. En rendement moyen FPS sur les jeux que nous avons testé, la carte GTX 1660 SUPER obtient un score de 93,3 FPS en résolution 1080p. Elle affiche 68,7 FPS en 1440p et arrive à fournir un frame rate de 40,3 en résolution 4K.

Voici une graphique de comparaison de performance en FPS de la carte GTX 1660 Super par rapport aux GTX 1660 et GTX 1060. La GTX 1660 Super est en moyenne à 1,3 fois plus rapide que la GTX 1060.

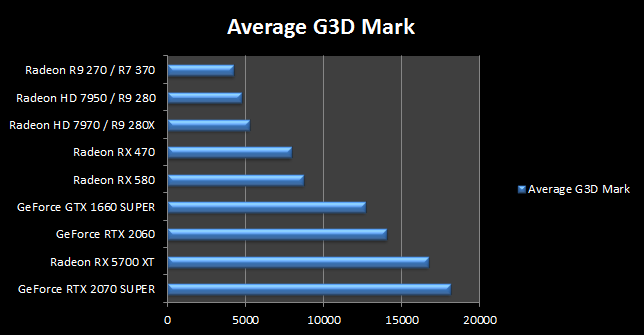

En testant la carte GTX 1660 Super sur G3D Mark, elle a pour score de 12 669. En la comparant avec les autres cartes telles que la Radeon RX 5700 XT, la GeForce RTX 2060, la Radeon RX 580, la GeForce RTX 2070 SUPER et bien d’autres, nous pouvons dire que sa performance est située entre la Radeon RX 580 et la GeForce RTX 2060. La Radeon RX 580 obtient un score G3D Mark de 8 748, soit à -30% de la GTX 1660 Super. La GeForce RTX 2060 obtient quant à elle un score de 14 047, soit à 10% de plus par rapport à laGTX 1660 Super.

Nous pouvons dire que la GTX 1660 Super affiche une performance assez bluffante, car en la comparant avec une carte AMD assez récente telle la Radeon RX 5700 XT, cette dernière obtient un score G3D Mark de 16 711. Ce qui se traduit par une efficacité de 32 %. Ce qui n’est pas du tout un gain énorme.

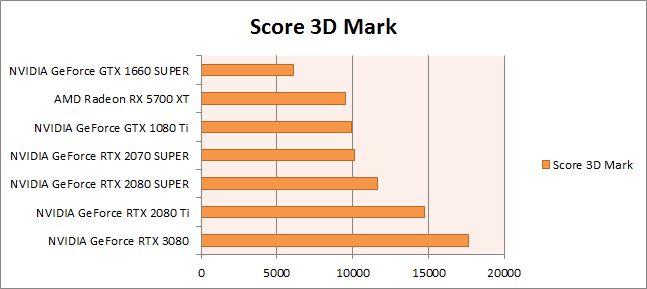

Sur 3DMark, la NVIDIA GeForce GTX 1660 SUPER obtient un score de 6 108. Voici une comparaison graphique de cette carte avec les modèles les plus récents du marché tels que la NVIDIA GeForce RTX 3080 (score 3D Mark 17669), NVIDIA GeForce RTX 2080 Ti (score 3D Mark 14723) et bien d’autres.

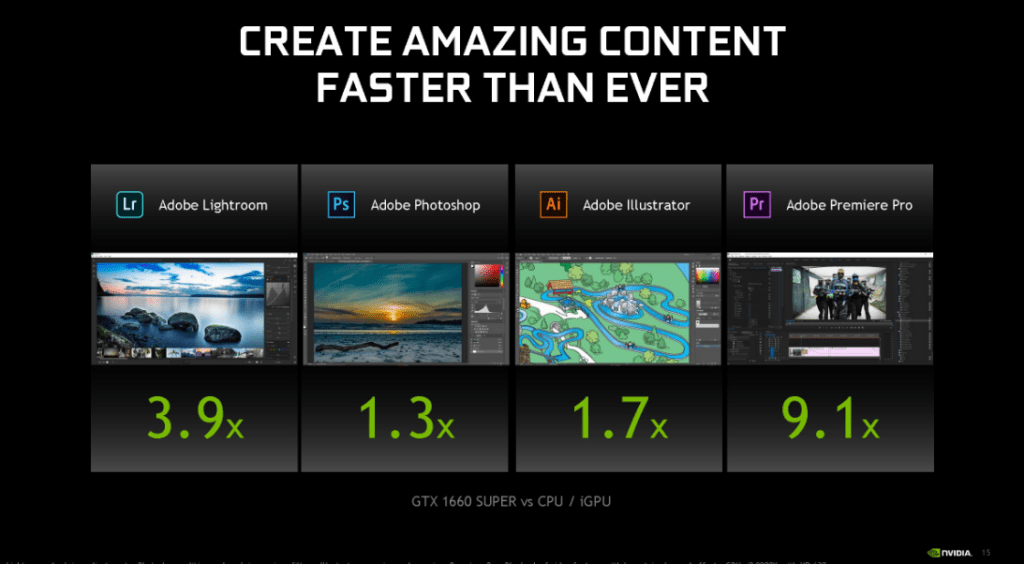

En ce qui concerne la création graphique, la GTX 1660 SUPER est plus efficace qu’un CPU/iGPU. Elle est en effet 3,9 fois plus rapide sur Adobe Lightroom et 9,1 fois plus en Adobe Première Pro. Elle affiche une performance de 1,3 fois plus avec le logiciel Adobe Photoshop et une rapidité de 1,7 fois plus sur Adobe illustrator.

En somme, la carte GTX 1660 Super affiche une bonne performance pour une carte de moyenne gamme. Avec son GPU TU116-300 muni de 1408 coeurs CUDA et surtout sa mémoire GDRR6 très rapide, la GTX 1660 Super arrive à tenir la promesse d’une carte fournissant un graphisme fluide en HD. Elle est disponible sur la toile pour un prix environnant les 250 €.